Hotline Tư Vấn - Bán Hàng Online

Mr. Tú: 0935132878

Mr. Phong: 0909424276

Hotline Tư Vấn - Mua Bán Buôn SL:

Ms. Sương: 0909210511

Ms. Vy: 0909210811

Mr. Đạt: 0937547855

Hotline Bảo Hành - Kĩ Thuật

Kiệt: 0902737314

Mr. Tú: 0935132878

Mr. Phong: 0909424276

Ms. Sương: 0909210511

Ms. Vy: 0909210811

Mr. Đạt: 0937547855

Kiệt: 0902737314

Free Shipping

NVIDIA luôn đi đầu trong việc mang sức mạnh của AI đến với người tiêu dùng thông qua GPU của mình, và một số công nghệ mới sắp ra mắt sẽ mở ra kỷ nguyên mới về chơi game và độ trung thực đồ họa trong những năm tới.

Nếu các giải pháp AI được nói đến nhiều trên báo chí, truyền hình và các trang tin tức hầu hết được quy cho các mô hình ngôn ngữ được tạo ra bởi các tập đoàn lớn và sau đó biến chúng thành các công cụ như chatbot hoặc trợ lý ảo AI, Nvidia còn đi xa hơn. Gen AI thực chất chỉ là một trong vô số giải pháp trí tuệ nhân tạo dựa trên kỹ thuật bắt máy mô phỏng hệ thần kinh trong não người, neural network. Một giải pháp khác chính là mô hình mô phỏng chuỗi protein xoắn của Google DeepMind, AlphaFold.

Nói về xử lý đồ họa máy tính, nhiều năm trước khi ChatGPT ra mắt, Nvidia đã ứng dụng deep learning để tạo ra giải pháp mang tên DLSS, được ra mắt cùng với thế hệ card đồ họa RTX kiến trúc Turing vào năm 2018.

Rồi mới đây nhất là Nvidia ACE, giải pháp tạo ra một thế giới ảo với các nhân vật vô cùng chân thực, ứng dụng AI kết hợp âm thanh và chuyển động môi, chuyển động khuôn mặt mà không cần cả một căn phòng được thế giới game gọi là “volume”, nơi ghi lại chuyển động cơ thể và khuôn mặt của diễn viên rồi ghép vào nhân vật ảo trong game.

Với những chia sẻ mới từ Nvidia, có thể thấy họ đang vô cùng nghiêm túc trong việc ứng dụng deep learning nói chung và Gen AI nói riêng vào ngành đồ họa máy tính và đồ họa game.

Trọng tâm của các giải pháp mới có lẽ là Ray Reconstruction, kết hợp cả xử lý dò tia thời gian thực và nâng cấp độ phân giải hình ảnh bằng cùng một thuật toán AI, để cải thiện đáng kể chất lượng hình ảnh hiển thị trên màn hình.

Trước khi nói về Ray Reconstruction, phải đề cập đến các giải pháp cho độ phân giải hình ảnh cao cấp như DLSS, FSR hoặc XeSS, được tạo ra bởi Nvidia, AMD và Intel.

Trong thời đại đồ họa trò chơi hiện nay, cuộc đua giữa các nhà sản xuất card đồ họa máy tính không còn chỉ là về sức mạnh xử lý thô, gọi là rasterization, biến các khung vector do CPU vẽ ra thành những điểm ảnh trên màn hình. Giờ các hãng còn phải cạnh tranh cả về việc, kiến trúc chip xử lý nào có thể nâng độ phân giải hình ảnh game lên độ phân giải gốc của màn hình hiệu quả nhất. Từ đó, những giải pháp như FSR hay DLSS cho phép anh em thưởng thức trò chơi qua cả hai bước, xử lý đồ họa thô với hiệu suất chip xử lý và giải pháp “nhân tạo” để tăng cả chất lượng hình ảnh và tốc độ khung hình.

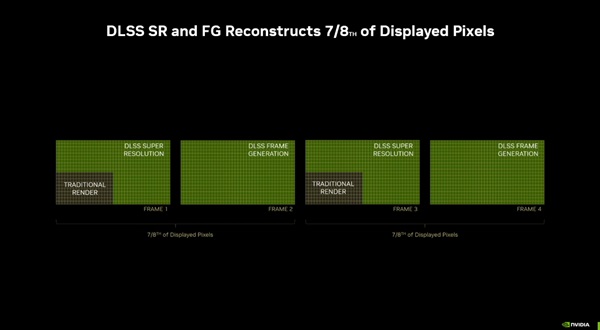

Nvidia đưa ra một con số rất hay, đó là nhờ công nghệ AI, thông thường CPU và GPU có thể tạo ra 1 pixel hiển thị trên màn hình, sau đó kết hợp với giải pháp nâng cấp hình ảnh bằng deep learning, toàn bộ hệ thống có thể tạo ra tổng cộng 8 pixel. Điều này có nghĩa là trong một số trường hợp, chẳng hạn như khi DLSS được bật ở chế độ Ultra Performance, độ phân giải render chỉ bằng 1/4 độ phân giải màn hình, tức là chơi game 4K, phần cứng máy tính sẽ render hình ảnh ở độ phân giải 1080p.

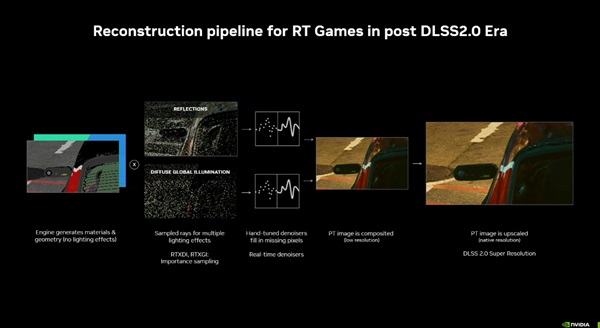

Trước khi có Ray Reconstruction, quá trình xử lý ray tracing theo thời gian thực trên card đồ họa RTX bị phụ thuộc vào một số khía cạnh và các bước xử lý. Bước đầu tiên là loại bỏ nhiễu trong các tia sáng, trong mắt anh em khi chơi game, là những điểm sáng chiếu trên bề mặt vật thể hoặc bóng tối hoặc phản xạ, càng nhiều tiếng ồn, nó càng trông tồi tệ. Đây là giải pháp được áp dụng DLSS 2, ra mắt cùng với thế hệ card RTX 30 series với kiến trúc Ampere. Tất nhiên, trò chơi vẫn đẹp, chẳng hạn như Control, nhưng giải pháp này không cho phép các nhà phát triển trò chơi tối ưu “nâng cấp độ phân giải hình ảnh” hoàn toàn, vì xử lý dò tia không hỗ trợ bước này.

Do đó, tốc độ khung hình sẽ không được hưởng lợi tối đa từ DLSS, hình ảnh sẽ bị vỡ và biến dạng, và tệ nhất, sẽ có vệt bóng kéo các vật thể nhỏ như gương chiếu hậu của ô tô trong Cyberpunk 2077, hoặc đường dây điện ở Saint Denis trong Red Dead Redemption 2.

Sau đó, Nvidia nhận ra rằng việc kết hợp cả xử lý dò tia thời gian thực và nâng cấp độ phân giải hình ảnh là điều cần thiết, vì vậy Ray Reconstruction đã ra đời. Cơ chế xử lý đồ họa này thay đổi quá trình xử lý dò tia, áp dụng giải pháp giảm nhiễu gọi là khử nhiễu hợp nhất.

Ở thời điểm mình đánh giá Cyberpunk 2077 bản 2.0, cũng như bản mở rộng cốt truyện Phantom Liberty, mình đề cập nhiều tới những thay đổi trong gameplay của phiên bản 2.0, cùng với những tinh túy của cốt truyện Phantom Liberty…

Để làm được điều này, Ray Reconstruction sử dụng một số mô hình AI được đào tạo để xử lý các tín hiệu hình ảnh động, chẳng hạn như bóng chuyển động, nguồn sáng và vật thể. So với bộ khử nhiễu do chính các lập trình viên viết, việc sử dụng AI giúp hiệu suất xử lý trên cấu hình máy tính được cải thiện đáng kể.

Về lý thuyết, Ray Reconstruction có thể trở thành một bước đột phá đáng kể trong ngành công nghiệp đồ họa máy tính tăng tốc AI, vì nó vừa tối ưu hóa quá trình dò tia, giúp cấu hình PC tiêu dùng dễ tiếp cận hơn với công nghệ đồ họa cao cấp này, vừa giảm giới hạn tải và yêu cầu phần cứng trong một số trường hợp. Và bằng cách giảm yêu cầu phần cứng, các nhà sản xuất trò chơi có thể tạo ra thế giới ảo đẹp hơn nhiều, tận dụng tối đa sức mạnh của PC.

Bước tiếp theo trong việc áp dụng AI vào đồ họa máy tính là gì? John Burgess của Nvidia gần đây tại sự kiện Đồ họa hiệu suất cao đã đề cập đến các xu hướng mới nổi trong đồ họa tăng tốc AI, xem xét kỹ hơn các ứng dụng có thể được xử lý ngay trên card đồ họa RTX GeForce và RTX cho máy trạm trên PC và máy trạm. Theo Burgess, AI có thể giúp xử lý nhiều tác vụ khác nhau, chứ không chỉ có mỗi việc xử lý DLSS để nâng cấp độ phân giải hình ảnh của trò chơi lên độ phân giải màn hình máy tính của anh em.

Trước đây, đơn vị TAP của Intel đã nói về những ý tưởng tương tự, nhìn thấy tiềm năng của AI cho đồ họa máy tính không chỉ để tạo ra các khung hình mới hoặc cải thiện độ phân giải hình ảnh của trò chơi. Một số giải pháp mới được Nvidia giới thiệu, áp dụng thuật toán AI, bao gồm:

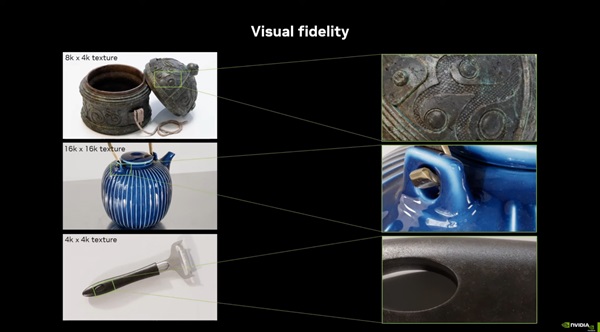

Đầu tiên là Neural Texture Compression, một ứng dụng AI để cải thiện độ rõ nét và chi tiết hình ảnh trong các trò chơi. Giải pháp này áp dụng một mạng lưới thần kinh gọi là MLP (Multi Layer Perception). Nhờ giải pháp này, tóm lại, tốc độ nén dữ liệu bề mặt đối tượng đồ họa trong bộ cài trò chơi sẽ tăng từ 4 đến 16 lần.

Nhờ đó, mô hình đối tượng 3D hiển thị trong các cảnh game sẽ sắc nét hơn nhưng dung lượng sẽ giữ nguyên hoặc nhẹ hơn. Dung lượng texture nhẹ hơn có nghĩa là yêu cầu bộ nhớ máy tính ít hơn và gánh nặng đối với VRAM, băng thông bộ nhớ và bộ nhớ đệm đều sẽ giảm, trong khi chất lượng hình ảnh chỉ có đẹp bằng, hoặc đẹp hơn:

Tiếp theo là NeuralVDB. Nó cũng là một giải pháp nén dữ liệu đồ họa, phục vụ cho các đối tượng có độ chi tiết cao như cây cối. Giải pháp này áp dụng 2 đến 4 MLP, để tạo ra tốc độ nén dữ liệu được cải thiện từ 10 đến 100 lần. Tại sự kiện SIGGRAPH 2022, Nvidia đã trình diễn cách mô hình AI tối ưu hóa dữ liệu đồ họa để xử lý các mô phỏng vật lý phức tạp như sóng nước, trong đó dữ liệu VRAM cần được xử lý giảm tới 25 lần, từ 15GB xuống 15GB… hơn 600 MB:

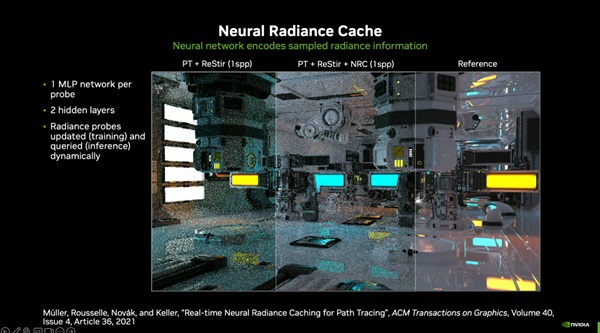

Thứ ba, Neural Radiance Cache sử dụng mạng thần kinh để xử lý và mã hóa dữ liệu ánh sáng ở một cấp độ. Giải pháp này sẽ được kết hợp với quy trình dựng hình đồ họa dò đường dẫn, tính toán đường đi của ánh sáng thay vì mô phỏng một số tia nhất định như Ray Tracing. Kết hợp hai giải pháp này, chất lượng hình ảnh đồ họa 3D sẽ được cải thiện đáng kể. Giải pháp AI này cho phép khử nhiễu hình ảnh nhanh hơn và tính toán đường đi của ánh sáng nhanh hơn.

Trên đây là những tính năng deep learning liên quan đến xử lý ray tracing thời gian thực khi xử lý đồ họa game. Trong khi đó, vẫn cần phải đề cập đến các quy trình cơ bản để trò chơi được hiển thị trên màn hình máy tính của bạn, đó là tô bóng (shader), và render hình ảnh trong thời gian thực.

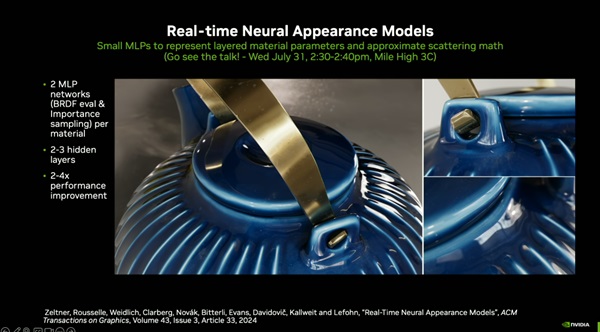

Tại SIGGRAPH 2024, Nvidia đã giới thiệu một thứ gọi là NAM, viết tắt của Neural Appearance Models. Giải pháp này ứng dụng AI để khắc họa và tái hiện bề mặt vật liệu, vật thể một cách chân thực hơn, nhờ các giải pháp tối ưu hơn so với giải pháp truyền thống. Các mạng lưới thần kinh hỗ trợ xử lý bề mặt của NAM được đào tạo để tìm hiểu các tính chất cơ bản của bề mặt của các vật thể và vật liệu thực tế. Sau đó áp dụng NAM dưới dạng AI tổng quát, áp dụng các chi tiết bề mặt đối tượng vào mô hình 3D của các vật phẩm và chi tiết trong trò chơi, vừa giúp chúng chân thực vừa giảm thời gian dựng hình.

Giải thích về NAM một cách chi tiết hơn, nó được xây dựng từ hai MLP, dùng để nhận dạng không gian và hình ảnh. MLP được sử dụng để phân tích và đánh giá giá trị BRDF (hàm phân phối phản xạ hai chiều) của bề mặt vật liệu và vật thể thực tế. MLP thứ hai sẽ được sử dụng để xử lý dữ liệu mẫu và hoạt động ở quy mô lớn. Kiến trúc của NAM khá giống với mô hình tạo sinh hình ảnh, bao gồm bộ mã hóa – giải mã, xử lý dữ liệu đầu vào để tạo ra các chi tiết bề mặt đối tượng chân thực nhất, chẳng hạn như trình diễn của Nvidia tại SIGGRAPH 2024 dưới đây:

Nhờ mô hình AI vận hành NAM, theo Nvidia, tiềm năng của thuật toán này là hiển thị các vật thể và bề mặt ở độ phân giải lên tới 16K chứ không chỉ 4K. Đồng thời, với việc áp dụng AI tạo ra, thời gian cần thiết để hiển thị hình ảnh 3D giảm từ 12 đến 24 lần so với giải pháp đổ bóng đồ thị thông thường, ở cùng độ phân giải kết cấu hình ảnh.

Trước mắt, hãy tóm tắt các khả năng của trí tuệ nhân tạo trong ngành đồ họa máy tính, tạo ra những cải tiến đáng kể trong thế giới đồ họa 3D:

Nhưng đồng thời, vẫn còn một số điều cần giải quyết để có thể ứng dụng hiệu quả trí tuệ nhân tạo vào ngành đồ họa máy tính:

Cụ thể hơn, khi mỗi luồng xử lý trong lõi chip GPU đang chạy và thiết lập lệnh chờ từng neural network riêng, phải tìm được cách để buộc tất cả các mạng thần kinh này hoạt động đồng bộ để tạo ra một sản phẩm hiển thị đồng nhất.

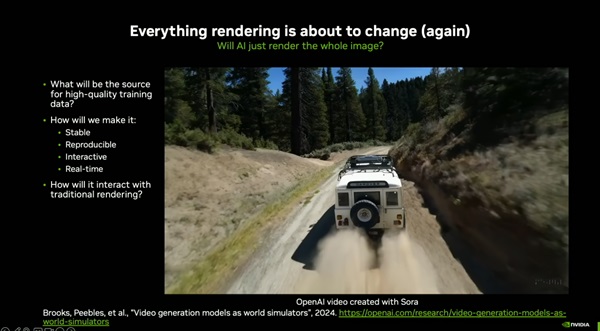

Một ví dụ của tương lai đồ họa 3D render bằng máy tính chính là Sora của OpenAI, xử lý dựa trên GPU máy chủ của Nvidia, mô tả một chiếc xe chạy băng qua con đường đất với dải bụi tạo ra từ bánh xe trải về phía sau cực kỳ chân thực, rồi chiếc xe cũng mô phỏng được hệ thống giảm xóc và trọng lượng của xe. Toàn bộ những hình ảnh được trình diễn đều được tạo ra từ AI. Và để tạo ra được đoạn video ngắn này, cần hàng chục nghìn GPU huấn luyện mô hình AI. Tham vọng là trong tương lai gần, khi sức mạnh của card đồ họa tiêu dùng mạnh hơn, hoàn toàn có thể tự tạo sinh video bằng AI, chạy trên card đồ họa trong máy tính của mọi người.

Nguồn: WCCFTech