Trong bối cảnh trí tuệ nhân tạo (AI) không ngừng phát triển, các mô hình ngôn ngữ lớn (LLM) như GPT-4 và Llama đã thu hút sự chú ý đáng kể với khả năng ấn tượng trong xử lý và tạo ngôn ngữ tự nhiên. Tuy nhiên, các mô hình ngôn ngữ nhỏ (SLM) đang nổi lên như một đối tác quan trọng trong cộng đồng mô hình AI, mang đến lợi thế độc đáo cho các trường hợp sử dụng cụ thể.

AMD Trình làng mô hình AI đầu tiên AMD-135M

AMD rất vui mừng được phát hành mô hình ngôn ngữ nhỏ đầu tiên của mình, AMD-135M với Giải mã Suy đoán. Công việc này thể hiện cam kết của hãng đối với cách tiếp cận mở đối với AI, điều này sẽ dẫn đến tiến bộ công nghệ bao trùm, đạo đức và đổi mới hơn, giúp đảm bảo rằng lợi ích của nó được chia sẻ rộng rãi hơn và những thách thức của nó được giải quyết một cách hợp tác hơn.

Theo thông tin chính thức của AMD, mô hình ngôn ngữ nhỏ (SLM) mang tên AMD-135M được các kỹ sư và các nhà nghiên cứu trí tuệ nhân tạo của hãng chip nước Mỹ phát triển, hiện tại dành cho mô hình ngôn ngữ lớn Llama của Meta. Thay vì là một mô hình AI để làm nần tảng cho những giải pháp chatbot xử lý on-device với tham số thấp, như Llama 3 8B hay Phi 3 của Meta và Microsoft, thì AMD-135M lại là một mô hình AI dùng để… hỗ trợ cho những mô hình AI tạo sinh phổ biến hiện nay.

AMD-135M tập trung tối ưu cho một giải pháp gọi là speculative decoding. Kỹ thuật này cho phép dự đoán những chuỗi token văn bản khi mô hình AI xử lý nội suy hiệu quả và tạo ra những nội dung chất lượng cao hơn. Ngay khi nội suy những token hiện tại, kỹ thuật speculative decoding sẽ cho phép dự đoán tiếp những token ngay sau đó, kèm thêm cơ chế xác thực để đảm bảo tính chính xác của những token mà AI tạo ra.

Với speculative decoding, mô hình AI nhỏ sẽ làm nhiệm vụ tạo ra những token tiềm năng, rồi mô hình lớn sẽ xác định token nào phù hợp và chất lượng cao nhất. Vậy là cùng lúc, hệ thống có thể nội suy cùng lúc nhiều token, nhưng không ảnh hưởng tiêu cực tới hiệu năng xử lý của hệ thống, đặc biệt là những thiết bị đầu cuối như laptop và smartphone anh em dùng hàng ngày.

Nếu không ứng dụng speculative decoding, quá trình nội suy nội dung của mô hình AI sẽ chỉ tập trung vào 1 token ở một thời điểm nhất định, tạm dịch là tự hồi quy (autoregressive approach). Giới hạn của giải pháp này là băng thông bộ nhớ không được tận dụng một cách tối đa, và thời gian nội suy bị ảnh hưởng.

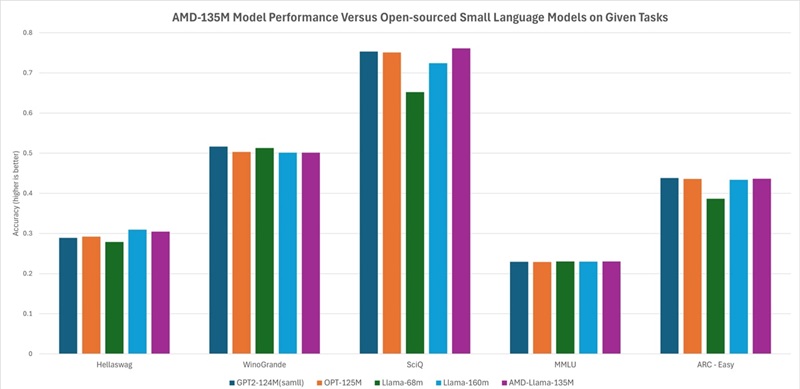

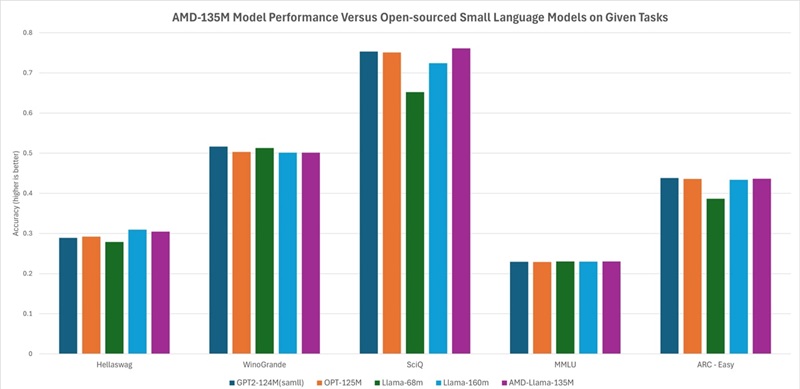

Nói riêng tới AMD-135M, mô hình ngôn ngữ nhỏ này được huấn luyện dựa trên những chip tăng tốc machine learning MI250, vận hành trên 670 tỷ token, với hai phiên bản AMD-Llama-135M và AMD-Llama-135M-code. Một phiên bản dùng để tối ưu quá trình nội suy văn bản và nội dung, và phiên bản còn lại tối ưu cho quá trình viết những dòng code lập trình.